새로운 인퍼런스MAX 벤치마크서 압도적 성능 과시

풀스택 최적화로 추론 비용은 15배 절감

AI 컴퓨팅 기술의 선두주자 엔비디아가 자사의 차세대 AI 플랫폼 ‘블랙웰(Blackwell)’이 AI 추론의 경제성을 완전히 새로운 차원으로 끌어올렸음을 입증했다. 엔비디아는 10월 13일, 새롭게 발표된 독립 벤치마크 ‘인퍼런스MAX(InferenceMAX) v1’에서 블랙웰 플랫폼이 모든 경쟁자를 압도하는 최고 성능을 기록했다고 밝혔다.

이번 결과는 단순한 성능 지표를 넘어, AI가 실제 가치를 창출하는 ‘추론’ 단계에서 처리량, 효율성, 비용 경쟁력까지 모두 잡았다는 것을 의미한다. 이는 엔비디아의 풀스택(Full-stack) 하드웨어·소프트웨어 공동 설계가 AI 데이터센터의 생산성과 투자수익률(ROI)을 어떻게 극대화하는지를 명확히 보여준다.

’15배 ROI’… 추론의 경제학을 바꾸다

AI가 단발성 답변에서 벗어나 여러 단계에 걸친 복잡한 추론 작업을 수행하게 되면서, AI 추론에 필요한 컴퓨팅 자원과 비용은 기하급수적으로 증가하고 있다. 이러한 상황에서 처음으로 실제 시나리오의 총 컴퓨팅 비용을 측정한 인퍼런스MAX v1 벤치마크의 등장은 시사하는 바가 크다.

결과는 충격적이었다. 엔비디아는 500만 달러(약 68억 원) 규모의 GB200 NVL72 시스템 투자를 통해 7,500만 달러(약 1,027억 원)에 달하는 토큰 수익을 창출할 수 있으며, 이는 무려 15배의 ROI에 해당한다고 밝혔다. 또한, 이전 세대 아키텍처 대비 백만 토큰당 비용을 15배까지 낮췄으며, 전력이 제한된 AI 팩토리 환경에서는 메가와트당 처리량을 10배 높여 더 높은 수익 창출이 가능함을 증명했다.

이안 벅(Ian Buck) 엔비디아 하이퍼스케일 및 고성능 컴퓨팅 부문 부사장은 “추론은 AI가 매일 가치를 창출하는 영역”이라며 “이번 결과는 엔비디아의 풀스택 접근 방식이 고객에게 필요한 성능과 효율성을 제공함을 보여준다”고 말했다.

하드웨어와 소프트웨어의 합작품, 압도적 성능의 비결

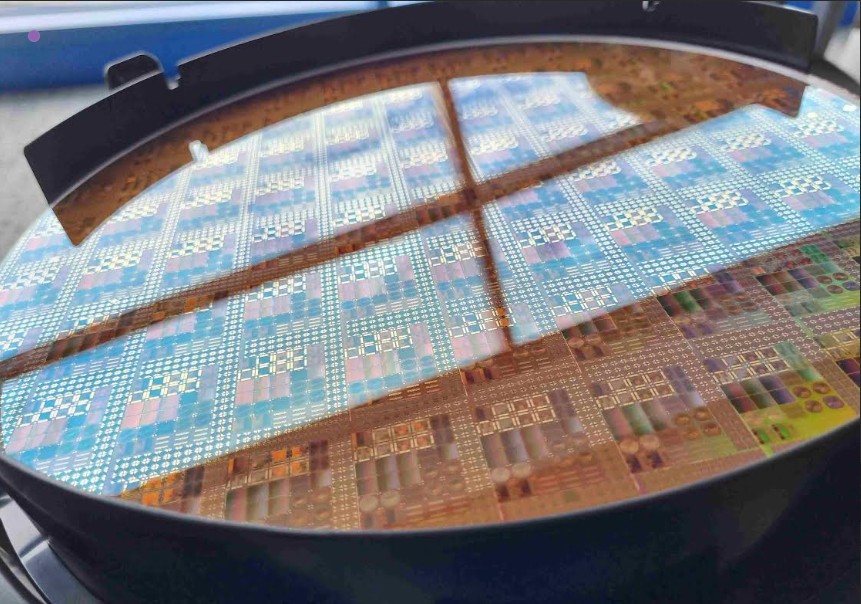

블랙웰의 이러한 리더십은 하드웨어와 소프트웨어의 극단적인 공동 설계에서 비롯된다. 엔비디아는 소프트웨어 최적화만으로도 지속적인 성능 향상을 이뤄내고 있다.

최신 소프트웨어 라이브러리인 텐서RT LLM(TensorRT LLM) v1.0은 고급 병렬화 기술과 추측 디코딩(speculative decoding) 같은 기법을 통해 gpt-oss-120b 모델의 처리량을 3배나 향상시켰다. 메타의 라마 3.3 70B와 같은 고밀도 AI 모델에서는 이전 세대인 H200 GPU 대비 GPU당 처리량이 4배 더 높은 것으로 나타났다.

이러한 성능의 기반에는 정확도 손실 없이 효율을 높이는 NVFP4 저정밀도 포맷, 72개의 GPU를 하나처럼 묶는 5세대 NV링크 기술 등 혁신적인 하드웨어 아키텍처가 자리 잡고 있다. 또한, 엔비디아는 오픈AI, 메타 등 선도적인 모델 개발사는 물론, vLLM과 같은 오픈소스 커뮤니티와 긴밀하게 협력하며 개방형 생태계를 통해 공유된 혁신을 가속화하고 있다.

인퍼런스MAX는 비용, 에너지 효율성, 처리량, 반응성 등 다양한 지표 간의 최적의 균형점을 보여주는 파레토 프론티어(Pareto frontier) 접근법을 사용한다. 이는 블랙웰이 특정 시나리오에만 최적화된 것이 아니라, 실제 기업 환경에서 가장 중요한 생산성과 ROI를 극대화하도록 설계되었음을 보여준다.

![[해설] ST, NXP MEMS 사업 인수 완료… “자동차·산업용 센서 시장 싹쓸이 나선다” [해설] ST, NXP MEMS 사업 인수 완료… “자동차·산업용 센서 시장 싹쓸이 나선다”](https://icnweb.kr/wp-content/uploads/2026/02/MEMS_NXP.png)

![[심층분석] AI 데이터센터가 삼킨 메모리 시장, ‘슈퍼사이클’ 넘어 ‘구조적 격변’ 시작됐다 [심층분석] AI 데이터센터가 삼킨 메모리 시장, ‘슈퍼사이클’ 넘어 ‘구조적 격변’ 시작됐다](https://icnweb.kr/wp-content/uploads/2026/01/memory-market-3player-1024web.png)

![[심층기획] 클라우드를 넘어 ‘현장’으로… 인텔, 산업용 엣지 AI의 판을 흔들다 [심층기획] 클라우드를 넘어 ‘현장’으로… 인텔, 산업용 엣지 AI의 판을 흔들다](https://icnweb.kr/wp-content/uploads/2026/01/Perplexity-image-Edge-AI-industry1b-700web.png)

![[피플] “생성형 AI 넘어 ‘피지컬 AI’의 시대로… 2026 하노버메세, 제조 혁신의 해법 제시” [피플] “생성형 AI 넘어 ‘피지컬 AI’의 시대로… 2026 하노버메세, 제조 혁신의 해법 제시”](https://icnweb.kr/wp-content/uploads/2026/02/R41_0775-HM26-von-press-900web.png)

![[이슈] 스마트 제조의 방패 ‘IEC 62443’, 글로벌 산업 보안의 표준으로 우뚝 [이슈] 스마트 제조의 방패 ‘IEC 62443’, 글로벌 산업 보안의 표준으로 우뚝](https://icnweb.kr/wp-content/uploads/2025/07/OT-security-at-automotive-by-Gemini-Veo-1024x582.png)

![[기자칼럼] 제어반의 다이어트, ‘워크로드 컨버전스’가 답이다… 엔지니어를 위한 실전 팁 7가지 [기자칼럼] 제어반의 다이어트, ‘워크로드 컨버전스’가 답이다… 엔지니어를 위한 실전 팁 7가지](https://icnweb.kr/wp-content/uploads/2026/01/generated-edge-AI-4-in-1-01-1024web.png)

![[그래프] 국회의원 선거 결과 정당별 의석수 (19대-22대) 대한민국 국회의원 선거 결과(정당별 의석 수)](https://icnweb.kr/wp-content/uploads/2025/04/main-image-vote-flo-web-2-324x160.jpg)