8세대 EC2 인스턴스 출시…

내장형 AI 가속과 압도적인 메모리 성능

고성능 클라우드 컴퓨팅 시대 주도

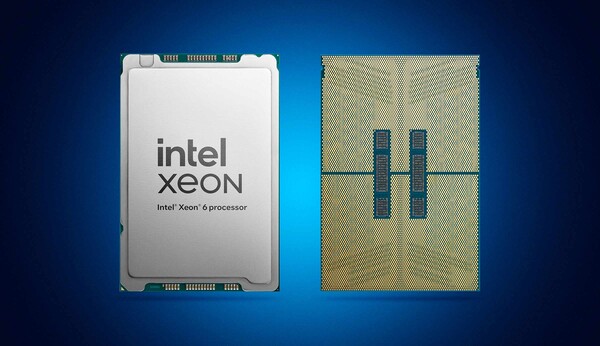

[아이씨엔 오승모 기자] 클라우드 컴퓨팅 시장의 두 거인, 인텔과 아마존웹서비스(AWS)가 다시 한번 손을 잡고 기술 혁신의 새로운 장을 열었다. 양사는 최근 P-코어를 탑재한 최신 ‘인텔® 제온® 6 프로세서’에 기반한 8세대 아마존 EC2(Amazon Elastic Compute Cloud) R8i 및 R8i-플렉스 인스턴스를 공식 출시한다고 발표했다. 이는 수년간 이어진 양사의 긴밀한 협력의 결과물로, AI와 실시간 데이터 처리 등 고성능을 요구하는 클라우드 환경에 최적화된 솔루션을 제공하는 것을 목표로 한다.

최근 기업 환경은 AI 모델 학습 및 추론, 대규모 데이터 분석, 규제 준수가 필수적인 금융 및 의료 워크로드 등 그 어느 때보다 높은 컴퓨팅 파워를 요구하고 있다. 이번에 출시된 새로운 EC2 인스턴스는 이러한 시장의 요구에 부응하며 성능과 비용 효율성이라는 두 마리 토끼를 모두 잡았다는 평가를 받는다.

압도적 성능 향상, AI 시대의 클라우드 인프라를 재정의하다

새로운 R8i 및 R8i-플렉스 인스턴스의 가장 큰 특징은 압도적인 성능 개선이다. AWS에 따르면, 신규 인스턴스는 이전 세대 대비 메모리 대역폭이 2.5배 향상되었으며, 가격 대비 성능은 15% 더 우수하다. 이는 클라우드 상에서 DDR5 메모리를 최대 7200 MT/s 속도로 지원함으로써 가능해졌으며, 인메모리 데이터베이스나 머신러닝(ML)과 같이 방대한 데이터를 빠르게 처리해야 하는 작업에서 병목 현상을 크게 줄여준다.

니샨트 메타(Nishant Mehta) AWS EC2 제품 관리 부사장은 “고객들은 가장 까다로운 워크로드의 속도에 맞춘 인프라를 필요로 한다”며 “인텔과의 협력을 통해 고객이 성능을 극대화하면서 동시에 비용을 절감할 수 있는 혁신적인 솔루션을 제공하게 되었다”고 밝혔다.

핵심은 ‘내장형 AI 가속’, 별도 가속기 의존도 낮춰

이번 제온 6 프로세서 기반 인스턴스는 단순한 연산 속도 향상을 넘어, AI 워크로드 처리에 특화된 기능을 프로세서 자체에 통합했다는 점에서 주목할 만하다. ‘인텔® AMX(Advanced Matrix Extensions)’라는 내장형 AI 가속 기능이 바로 그것이다.

인텔 AMX는 AI 추론 및 머신러닝 성능을 최대 2배까지 향상시켜, 이전에는 별도의 고가 GPU 가속기에 의존해야 했던 작업을 CPU만으로도 효율적으로 처리할 수 있게 해준다. 이는 기업들이 복잡한 AI 인프라를 보다 간소화하고, 배포 및 관리의 어려움을 줄여 AI 기술 도입의 장벽을 낮추는 효과를 가져온다.

로낙 싱할(Ronak Singhal) 인텔 선임 펠로우는 “이번 출시는 AWS와의 협업에서 중요한 이정표”라며 “AI 가속화, 메모리 성능 향상, 쉬운 배포를 통해 고객이 더 빠르게 인사이트를 얻고 강력한 투자수익률(ROI)을 달성하도록 지원하는 인프라를 함께 구축했다”고 강조했다.

이미 넷플릭스(Netflix), 크라우드스트라이크(CrowdStrike)와 같은 업계 선도 기업들은 제온 6 기반 인스턴스를 조기 도입하여 AI 기반 클라우드 네이티브 애플리케이션을 구동하고 있으며, 컴퓨팅 처리량과 AI 성능, 인프라 효율성 측면에서 뚜렷한 개선 효과를 보고 있는 것으로 알려졌다. 이번 협력은 클라우드 생태계의 핵심 기술 공급자로서 인텔의 입지를 더욱 공고히 하고, AI 시대의 기술 혁신을 가속화하는 중요한 계기가 될 전망이다.

![[기획] 머스크의 2026년 전망.. “2026 AGI의 승부처, 반도체 칩이 아니라 ‘태양’에 있다” [기획] 머스크의 2026년 전망.. “2026 AGI의 승부처, 반도체 칩이 아니라 ‘태양’에 있다”](https://icnweb.kr/wp-content/uploads/2026/01/moonshots-with-peter-and-elon-musk-zoom-1024x591.png)

![[분석] 엔비디아 블랙웰, 2026년 ‘1.3조 달러’ AI 인프라 시장의 독점적 지배자 부상 [분석] 엔비디아 블랙웰, 2026년 ‘1.3조 달러’ AI 인프라 시장의 독점적 지배자 부상](https://icnweb.kr/wp-content/uploads/2026/01/NVIDIA-CEO-GTC-blackwell-900web.png)

![[마켓] 엔비디아, 연 매출 1,000억 달러 시대 개막… AI 반도체 점유율 50% 육박 [마켓] 엔비디아, 연 매출 1,000억 달러 시대 개막… AI 반도체 점유율 50% 육박](https://icnweb.kr/wp-content/uploads/2026/01/Nvidia-bluefield-4-ces2026-1024web.png)

![[기자칼럼] 클라우드를 넘어 현장으로… 엣지·피지컬·온디바이스 AI, ‘산업 지능화’의 3대 축으로 부상 [기자칼럼] 클라우드를 넘어 현장으로… 엣지·피지컬·온디바이스 AI, ‘산업 지능화’의 3대 축으로 부상](https://icnweb.kr/wp-content/uploads/2026/01/perplexity-image-Edge-AI-web.png)

![[그래프] 국회의원 선거 결과 정당별 의석수 (19대-22대) 대한민국 국회의원 선거 결과(정당별 의석 수)](https://icnweb.kr/wp-content/uploads/2025/04/main-image-vote-flo-web-2-324x160.jpg)