OpenAI 워크로드용 NVIDIA GB300 NVL72 대규모 클러스터 첫 공급

수십만 개 GPU로 확장 계획

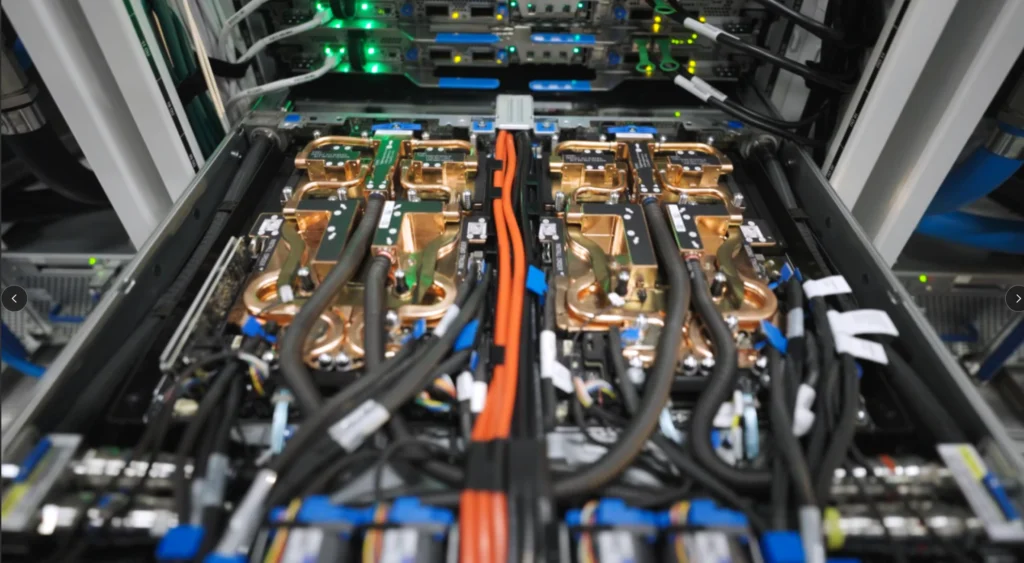

마이크로소프트(Microsoft) 애저(Azure)가 OpenAI 워크로드를 위해 4,600개 이상의 NVIDIA GB300 NVL72로 구성된 첫 대규모 프로덕션 클러스터를 제공한다고 밝혔다. 차세대 NVIDIA 인피니밴드(InfiniBand) 네트워크로 연결된 NVIDIA Blackwell Ultra GPU를 탑재한 이 클러스터는, 향후 마이크로소프트 AI 데이터센터 전반에 걸쳐 수십만 개의 GPU로 확장될 계획의 시작점이다.

이번 배포는 모델 훈련 시간을 수개월에서 수 주로 단축하고, 추론 워크로드에서 높은 처리량을 제공하는 것을 목표로 한다. 또한, 수백조 개의 파라미터를 가진 모델의 훈련을 최초로 지원하게 될 예정이다.

이안 벅(Ian Buck) 엔비디아 하이퍼스케일 및 고성능 컴퓨팅 부문 부사장은 “MS 애저의 NVIDIA GB300 NVL72 슈퍼클러스터 출시는 프론티어 AI 발전의 흥미로운 단계”라며, “OpenAI가 조 단위 파라미터 모델을 서비스하는 데 필요한 슈퍼컴퓨팅 엔진을 제공하며 가속 컴퓨팅의 새로운 표준을 설정했다”고 평가했다.

ND GB300 v6 VM으로 AI 성능 기준 재정의

MS 애저는 엔비디아 블랙웰(Blackwell) 아키텍처 기반의 ND GB200 v6 가상머신(VM)에 이어, 추론 모델, 에이전트 AI 시스템, 멀티모달 생성형 AI에 최적화된 ND GB300 v6 VM을 새롭게 선보였다. 랙 스케일 시스템으로 구축된 각 랙은 18개의 VM과 총 72개의 GPU를 포함하며 주요 사양은 다음과 같다.

- 72개의 NVIDIA Blackwell Ultra GPU (36개의 NVIDIA Grace CPU 포함)

- 차세대 NVIDIA Quantum-X800 InfiniBand를 통한 GPU당 800Gb/s의 랙 간 스케일아웃 대역폭

- 랙 내 130TB/s의 NVIDIA NVLink 대역폭

- 37TB의 고속 메모리

- 최대 1,440 페타플롭스(PFLOPS)의 FP4 텐서 코어 성능

슈퍼컴퓨팅 스케일을 위한 통합 시스템 설계

이번 인프라는 컴퓨팅, 메모리, 네트워킹, 데이터센터, 냉각, 전력 등 스택의 모든 계층을 통합된 시스템으로 재구성한 결과물이다. 랙 수준에서는 NVLink와 NVSwitch가 메모리 및 대역폭 제약을 줄여 랙 내에서 초당 130TB의 데이터 전송을 가능하게 한다.

랙을 넘어선 확장을 위해 애저는 현재 가장 빠른 네트워킹 패브릭인 NVIDIA Quantum-X800 InfiniBand를 사용한 풀 팻트리(full fat-tree), 논블로킹(non-blocking) 아키텍처를 배포했다. 이를 통해 통신 오버헤드를 최소화하며 수만 개의 GPU로 훈련을 확장할 수 있다. 또한 NVIDIA SHARP와 같은 기능은 스위치 내에서 연산을 수행하여 집합 연산(collective operations)을 가속화하고 유효 대역폭을 두 배로 늘린다.

데이터센터 인프라 측면에서는 독립형 열 교환 장치와 시설 냉각을 사용하는 첨단 냉각 시스템을 통해 물 사용량을 최소화하면서 고밀도 클러스터의 열 안정성을 유지한다. 또한 ND GB300 v6 VM 클래스의 높은 에너지 밀도와 동적 부하 분산을 지원할 수 있는 새로운 전력 분배 모델을 개발 및 배포하고 있다.

MS 애저는 전 세계적으로 GB300 배포를 확대함에 따라, 고객들이 이전 세대보다 훨씬 짧은 시간 안에 새로운 모델을 훈련하고 배포할 수 있을 것으로 기대하고 있다.

![[해설] ST, NXP MEMS 사업 인수 완료… “자동차·산업용 센서 시장 싹쓸이 나선다” [해설] ST, NXP MEMS 사업 인수 완료… “자동차·산업용 센서 시장 싹쓸이 나선다”](https://icnweb.kr/wp-content/uploads/2026/02/MEMS_NXP.png)

![[심층분석] AI 데이터센터가 삼킨 메모리 시장, ‘슈퍼사이클’ 넘어 ‘구조적 격변’ 시작됐다 [심층분석] AI 데이터센터가 삼킨 메모리 시장, ‘슈퍼사이클’ 넘어 ‘구조적 격변’ 시작됐다](https://icnweb.kr/wp-content/uploads/2026/01/memory-market-3player-1024web.png)

![[심층기획] 클라우드를 넘어 ‘현장’으로… 인텔, 산업용 엣지 AI의 판을 흔들다 [심층기획] 클라우드를 넘어 ‘현장’으로… 인텔, 산업용 엣지 AI의 판을 흔들다](https://icnweb.kr/wp-content/uploads/2026/01/Perplexity-image-Edge-AI-industry1b-700web.png)

![[피플] “생성형 AI 넘어 ‘피지컬 AI’의 시대로… 2026 하노버메세, 제조 혁신의 해법 제시” [피플] “생성형 AI 넘어 ‘피지컬 AI’의 시대로… 2026 하노버메세, 제조 혁신의 해법 제시”](https://icnweb.kr/wp-content/uploads/2026/02/R41_0775-HM26-von-press-900web.png)

![[이슈] 스마트 제조의 방패 ‘IEC 62443’, 글로벌 산업 보안의 표준으로 우뚝 [이슈] 스마트 제조의 방패 ‘IEC 62443’, 글로벌 산업 보안의 표준으로 우뚝](https://icnweb.kr/wp-content/uploads/2025/07/OT-security-at-automotive-by-Gemini-Veo-1024x582.png)

![[기자칼럼] 제어반의 다이어트, ‘워크로드 컨버전스’가 답이다… 엔지니어를 위한 실전 팁 7가지 [기자칼럼] 제어반의 다이어트, ‘워크로드 컨버전스’가 답이다… 엔지니어를 위한 실전 팁 7가지](https://icnweb.kr/wp-content/uploads/2026/01/generated-edge-AI-4-in-1-01-1024web.png)

![[그래프] 국회의원 선거 결과 정당별 의석수 (19대-22대) 대한민국 국회의원 선거 결과(정당별 의석 수)](https://icnweb.kr/wp-content/uploads/2025/04/main-image-vote-flo-web-2-324x160.jpg)