엔비디아 호퍼(nvidia hopper)가 페이스북 운영사인 메타(Meta)의 지능형 데이터센터를 위한 차세대 AI 플랫폼인 그랜드 테톤(Grand Teton)을 지원에 나선다.

오픈 컴퓨팅 프로젝트 컨퍼런스인 2022 OCP 글로벌 서밋에서 메타 인프라 하드웨어 부사장인 알렉시스 비욜린(Alexis Bjorlin)은 “그랜드 테톤 시스템은 이전 세대 자이언(Zion) EX 플랫폼에 비해 더 많은 메모리, 네트워크 대역폭, 컴퓨팅 용량을 제공한다”고 밝혔다.

새롭게 메타가 구축하는 AI 모델은 페이스북에서 뉴스 피드, 콘텐츠 추천, 혐오 발언 식별과 같은 서비스에서 광범위하게 활용될 예정이다.

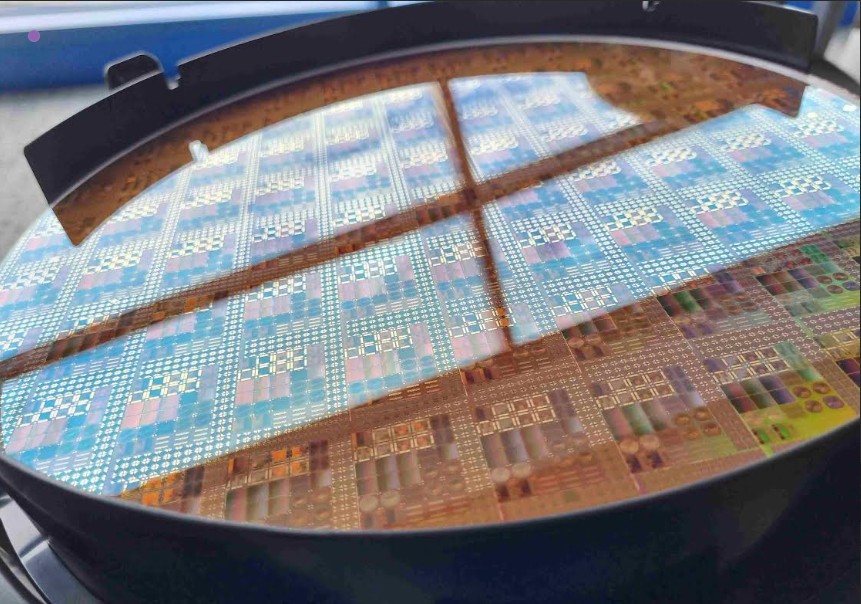

와이오밍의 국립공원에 있는 산의 이름을 따서 명명된 그랜드 테톤(Grand Teton)은 엔비디아 H100 텐서 코어(Tensor Core) GPU를 사용해 크기와 기능이 빠르게 성장해 더 많은 컴퓨팅이 필요한 AI 모델을 교육 및 실행한다.

“엔비디아 호퍼 GPU는 더 큰 에너지 효율성과 향상된 성능으로 가속화된 컴퓨팅을 제공하는 동시에 확장성을 추가하고 비용을 낮추면서 세계의 어려운 문제를 해결하기 위해 제작됐다.

이안 벅(Ian Buck), 엔비디아 하이퍼스케일 및 고성능 컴퓨팅 담당 부사장

H100의 기반으로 하는 엔비디아 호퍼 아키텍처는 이러한 신경망 작업을 가속화하기 위한 트랜스포머 엔진을 포함하고 있다. 이는 자연어 처리에서 의료, 로보틱스 등으로 확장되는 애플리케이션 세트를 처리할 수 있기 때문에 기반 모델이라고 불린다.

엔비디아 H100은 성능과 에너지 효율성을 위해 설계됐다. H100 가속 서버는 하이퍼스케일 데이터센터에 있는 수천 대의 서버에 걸쳐 엔비디아 네트워킹과 연결될 경우 CPU 전용 서버보다 300배 더 에너지 효율적일 수 있다.

엔비디아 하이퍼스케일 및 고성능 컴퓨팅 담당 부사장인 이안 벅(Ian Buck)은 “메타가 H100 기반 그랜드 테톤 플랫폼을 공유함으로써 전 세계 시스템 빌더는 곧 하이퍼스케일 데이터센터 컴퓨팅 인프라를 위한 개방형 설계에 액세스하여 산업 전반에 걸쳐 AI를 강화하게 될 것이다”라고 말했다.

![[해설] ST, NXP MEMS 사업 인수 완료… “자동차·산업용 센서 시장 싹쓸이 나선다” [해설] ST, NXP MEMS 사업 인수 완료… “자동차·산업용 센서 시장 싹쓸이 나선다”](https://icnweb.kr/wp-content/uploads/2026/02/MEMS_NXP.png)

![[심층분석] AI 데이터센터가 삼킨 메모리 시장, ‘슈퍼사이클’ 넘어 ‘구조적 격변’ 시작됐다 [심층분석] AI 데이터센터가 삼킨 메모리 시장, ‘슈퍼사이클’ 넘어 ‘구조적 격변’ 시작됐다](https://icnweb.kr/wp-content/uploads/2026/01/memory-market-3player-1024web.png)

![[심층기획] 클라우드를 넘어 ‘현장’으로… 인텔, 산업용 엣지 AI의 판을 흔들다 [심층기획] 클라우드를 넘어 ‘현장’으로… 인텔, 산업용 엣지 AI의 판을 흔들다](https://icnweb.kr/wp-content/uploads/2026/01/Perplexity-image-Edge-AI-industry1b-700web.png)

![[피플] “생성형 AI 넘어 ‘피지컬 AI’의 시대로… 2026 하노버메세, 제조 혁신의 해법 제시” [피플] “생성형 AI 넘어 ‘피지컬 AI’의 시대로… 2026 하노버메세, 제조 혁신의 해법 제시”](https://icnweb.kr/wp-content/uploads/2026/02/R41_0775-HM26-von-press-900web.png)

![[이슈] 스마트 제조의 방패 ‘IEC 62443’, 글로벌 산업 보안의 표준으로 우뚝 [이슈] 스마트 제조의 방패 ‘IEC 62443’, 글로벌 산업 보안의 표준으로 우뚝](https://icnweb.kr/wp-content/uploads/2025/07/OT-security-at-automotive-by-Gemini-Veo-1024x582.png)

![[기자칼럼] 제어반의 다이어트, ‘워크로드 컨버전스’가 답이다… 엔지니어를 위한 실전 팁 7가지 [기자칼럼] 제어반의 다이어트, ‘워크로드 컨버전스’가 답이다… 엔지니어를 위한 실전 팁 7가지](https://icnweb.kr/wp-content/uploads/2026/01/generated-edge-AI-4-in-1-01-1024web.png)

![[그래프] 국회의원 선거 결과 정당별 의석수 (19대-22대) 대한민국 국회의원 선거 결과(정당별 의석 수)](https://icnweb.kr/wp-content/uploads/2025/04/main-image-vote-flo-web-2-324x160.jpg)